7 imperatywów CARTA – Continuous Adaptive Risk and Trust Assessment by Gartner

W 2018 roku, Neil MacDonald z Gartner poczynił następujące założenia:

- Do 2020 r. 25% inicjatyw biznesowych przyjmie podejście CARTA – w porównaniu z mniej niż 5% w 2017 r.

- Do 2020 r. kognitywne analizy bezpieczeństwa będą wykonywać od 15% do 20% funkcji reagowania na zagrożenia – obecnie wykonywane przez ludzi.

- Do 2020 r. 60% firm będzie integralną częścią większych cyfrowych ekosystemów biznesowych.

Oczywiście rok 2020 był nie do przewidzenia. Na ten moment dalej czekam na dane jednak możemy z powodzeniem założyć, że w związku z przymusową cyfryzacją – wartość z punktu trzeciego może dochodzić do 80%.

Właściwie od wynalezienia tajnych informacji i odkrycia cennych zasobów, ludzie zabiegają o to by skutecznie je chronić. Ocena ryzyka sposobu dostępu w świecie fizycznym – jego zakresu i liczby osób upoważnionych – już jest wystarczająco trudna i zajmuje wysokie miejsce wśród biznesowych priorytetów. W świecie cyfrowym poziom ryzyka dla Twoich zasobów zmienia się z szybkością założenia nowego e-maila. Nie mając jasnego obrazu ryzyka w swoich organizacjach, administratorzy bezpieczeństwa chronią dane w jedyny możliwy sposób – stosując restrykcyjne środki w myśl zasady „least privilege”. To powoduje, że system mówi „nie”, kiedy powinien w przemyślany sposób powiedzieć „może” lub „tak, ale z ograniczeniami”. Wywołuje to frustrację użytkowników, którzy próbują obejść zabezpieczenia, co z kolei wywołuje więcej alertów i zajmuje czas analitykom bezpieczeństwa… i koło się zamyka.

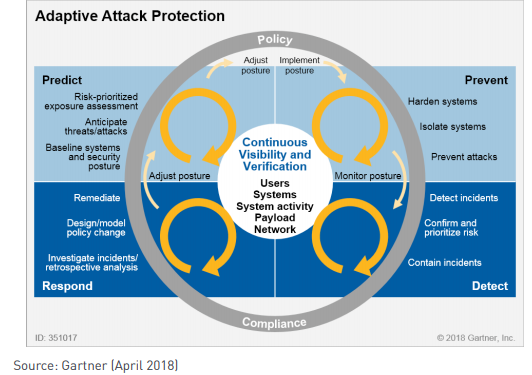

Odpowiedź Gartnera to CARTA – Continuous Adaptive Risk and Trust Assessment – podejście do oceny ryzyka i zaufania do użytkownika jako do procesu. Zakłada ciągłe monitorowanie i analizy systemu jako punkt wyjścia, umożliwiając szybkie wykrywanie anomalii behawioralnych i reagowanie na nie – innymi słowy, wychwytywanie i reagowanie na ryzykowne działania. Fundamentem tego podejścia jest założenie, że każde złośliwe zachowanie poprzedzone jest symptomami (które stopniowo powodują wzrost ryzyka danego użytkownika) – jeżeli dobrze się je rozpozna, można powstrzymać „ryzykownego” użytkownika nim będzie za późno.

Cały proces składa się z 4 obszarów – w których wyróżnia się kluczowe działania – obrazuje to grafika powyżej. Należy spojrzeć na to – jak, kiedy i dlaczego ludzie wchodzą w interakcje z wrażliwymi danymi, korelując zachowanie z kontekstem działań użytkowników i dopiero na tej podstawie oceniając ryzyko.

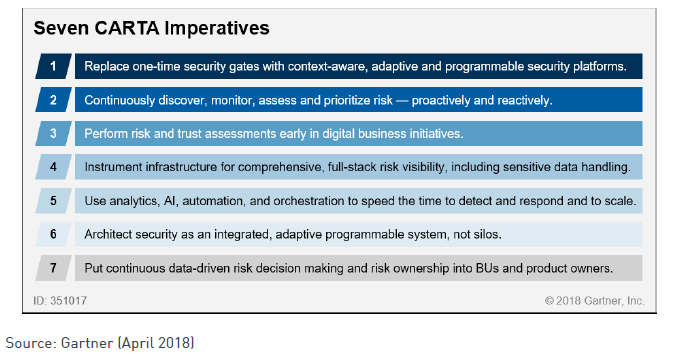

CARTA opiera się na 7 zasadach:

Imperatyw #1: Zastąp statycznie walidujące bramy bezpieczeństwa platformami bezpieczeństwa uwzględniającymi kontekst i zmienność poziomu ryzyka

Obecnie znaczna część istniejącej infrastruktury cyberbezpieczeństwa opiera się na jednorazowych decyzjach przy użyciu predefiniowanych list „złych” i „dobrych” – adresów IP, kont, operacji. Podejście to wadliwe z dwóch głównych powodow:

- nie ma wcześniej istniejącej sygnatury dla ataku zero-day lub ukierunkowanego APT.

- gdy złoczyńcy (i zagrożenia wewnętrzne) uzyskali uwierzytelniony dostęp ich działalność „poza bramką” jest niewidoczna. Po przyznaniu dostępu administratorzy mają ograniczony wgląd w działania użytkowników, systemów i kodu wykonywalnego.

Aby to zrekompensować, poddajemy użytkowników coraz dłuższym skanom w poszukiwaniu złośliwego oprogramowania i coraz bardziej rygorystycznemu reżimowi dotyczącemu haseł. W daremnym dążeniu do odpowiedzi na pytanie – przydzielić dostęp czy nie? Nasza początkowa decyzja nie może być idealna – ponieważ stale oceniamy konsekwencje tej początkowej decyzji. Dlatego CARTA odchodzi od jednorazowych decyzji dotyczących autoryzacji w kierunku ciągle ewaluowanych decyzji opartych na poziomie ryzyka konta użytkownika.

Imperatyw #2: Wykrywanie, monitorowanie, ocena i ustalanie priorytetów ryzyka – proaktywnie i reaktywnie

Tradycyjna infrastruktura bezpieczeństwa traktuje ryzyko i zaufanie jako binarne i stałe i często wywodzi zaufanie z własności systemu. To nie wystarczy do wsparcia biznesu, w którym konieczne jest zapewnienie dostępu do systemów i danych partnerom i klientom w dowolnym miejscu i czasie na dowolnym urządzeniu, często z infrastruktury, której nie posiadamy ani nie kontrolujemy.

Ryzyko i zaufanie rosną i maleją w oparciu o kontekst i zachowania jednostek w czasie trwania sesji (i względem linii bazowych ustalonych między sesjami). W oparciu o zaobserwowane wzorce można opracować modele ryzyka i zaufania. Jeśli ryzyko użytkownika lub jego zachowania staje się zbyt wysokie i przeważa nad zaufaniem, możemy podjąć kroki w celu zmniejszenia ryzyka lub zwiększenia zaufania podmiotu i żądanych działań.

- Zwiększenie zaufania: np. żądanie silniejszego uwierzytelnienia, aby zwiększyć naszą pewność, że użytkownik jest rzeczywiście tym, za kogo się podaje. Alternatywnie, użytkownik może być ograniczony do pobierania plików tylko na zaufane urządzenie.

- Zmniejszenie ryzyka: na przykład opakuj zawartość w zarządzanie prawami cyfrowymi podczas pobierania lub, alternatywnie, pobieranie może zostać całkowicie zablokowane.

Imperatyw #3: Przeprowadzaj oceny ryzyka i zaufania na wczesnym etapie inicjatyw cyfrowych

Wcześniejsze imperatywy koncentrowały się na bezpieczeństwie operacyjnym i ochronie przed ryzykiem w czasie wykonywania procesu. Jednak ów proces jest wzbogacany o coraz to nowe elementy infrastruktury – fizyczne i logiczne. Rozbudowa ta jest przeprowadzana m.in. poprzez:

- Rozwój aplikacji, usług i produktów.

- Zakup systemów IT.

- Wykorzystanie nowych usług SaaS, PaaS czy IaaS.

- Pobieranie nowych aplikacji i usług do instalacji lokalnej.

- Wybór i wdrażanie nowych technologii operacyjnych (OT) i urządzeń Internetu rzeczy (IoT).

- Otwieranie wewnętrznych systemów i danych przez interfejsy programowania aplikacji API.

We wszystkich tych obszarach bezpieczeństwo informacji boryka się z tymi samymi problemami, które opisaliśmy w poprzednich sekcjach – nadmiernym poleganiem na jednorazowych, intensywnych ocenach typu ZŁY/DOBRY. Nie możemy oceniać systemu bez uwzględnienia całego otoczenia – innych systemów, procesów i użytkowników. Wraz ze zmianą otoczenia – zmianie ulega poziom ryzyka systemu. W tabeli poniżej prezentujemy zasadniczą różnicę pomiędzy ciągłym, proaktywnym ocenaniem poziomu ryzyko – a reaktywnym podejściem:

Tabela: Proaktywne i reaktywne wykrywanie i ocena ryzyka

| Obszar bezpieczeństwa | Podejście Proaktywne | Podejście Reaktywne |

|---|---|---|

| Obrona przed cyberatakami | • Gdzie i w jaki sposób atakujący będą celować? Jak realne jest zagrożenie? • Jak powinienem dostosować swoją postawę bezpieczeństwa, aby zmniejszyć ekspozycję na zagrożenie? • Co mogę zrobić proaktywnie, aby zwiększyć powierzchnię ataku? • Jak mogę ustalić priorytety ryzyka w moich działaniach naprawczych? | • Gdzie jestem naruszony? • Czy te ataki są prawdziwe i jakie incydenty stanowią największe ryzyko? |

| Zarządzanie tożsamością i dostępem (IAM) | • Gdzie i jak użytkownicy będą potrzebować dostępu? (Na przykład do nowych aplikacji SaaS, aplikacji BU itp.) • Jak powszechny jest ten dostęp? • Jakie to ryzyko oznacza? • Jak mogę zmniejszyć ryzyko stosując mechanizmy kontroli (zarządzanie dostępem uprzywilejowanym, uwierzytelnianie wieloskładnikowe)? • Jak krytyczne i wrażliwe są te zasoby? • Jak mogę zapewnić wystarczający dostęp do danego zasobu na czas? • Jakiej pewności, że użytkownik jest tym, za kogo się podaje, zanim udzielę dostępu? | • Gdzie wzorce dostępu / użytkowania użytkowników stanowią wystarczające ryzyko, że muszę zareagować? Na ile jestem pewien, że incydent nie jest fałszywie pozytywny? • Jak cenny jest ten użytkownik & system/dane, do których uzyskują dostęp? •Jaki jest obecny poziom zagrożenia? • Czy istnieje wzorzec podejrzanej aktywności wśród wielu użytkowników / domen? • Gdzie dostęp użytkownika jest nadmiernie dozwolony? |

| Bezpieczeństwo danych | • Gdzie w moim przedsiębiorstwie są tworzone wrażliwe dane? • Gdzie są tworzone i przechowywane poufne dane poza moim przedsiębiorstwem? • Co jest uważane za „wartościowe” i dlaczego? • W jaki sposób chronione są wrażliwe/cenne dane? • Czy zarządza się ryzykiem? | • Gdzie dochodzi do niewłaściwego obchodzenia się z wrażliwymi danymi? • Jak wrażliwe/wartościowe są te dane? • Czy stanowi to wystarczające ryzyko, że muszę odpowiedzieć? |

| Zarządzanie ciągłością biznesową (BCM) i cyberresilience | • Jakie obszary/procesy biznesowe mają największy wpływ na przychody w przypadku utraty usługi? • Które systemy to obsługują? | W przypadku podejrzenia awarii: • Czy awaria jest potwierdzona? • Jakie procesy biznesowe i przychody są bezpośrednio zagrożone? • Jakie systemy/procesy należy najpierw przywrócić? |

Imperatyw #4: Infrastruktura bezpieczeństwa zapewniająca pelną widoczność ryzyka (risk full-stack), w tym przetwarzanie wrażliwych danych

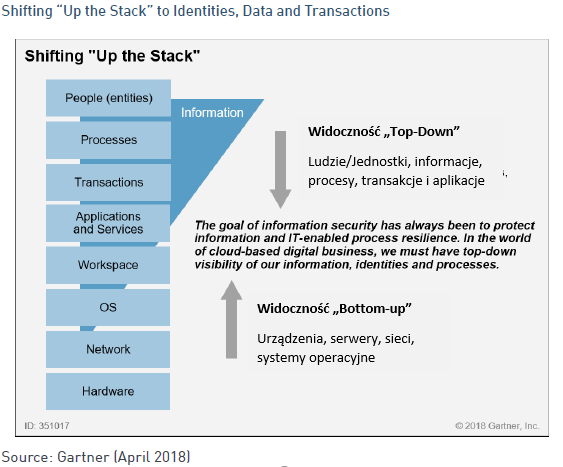

Celem powinna być widoczność zachowań w sieci i na urządzeniach końcowych, gdy tylko jest to możliwe. Jednocześnie tradycyjna infrastruktura bezpieczeństwa była nadto od tego uzależniona. Dlaczego? Ponieważ takie podejście nie zadziała, gdy nie będziemy już właścicielami sieci, serwera, OS czy aplikacji – jak to się dzieje w modelu chmurowym. Musimy zatem dostosować się do widoczności i ochrony informacji, aplikacji i danych, jak w przeszłości chroniliśmy sieci i punkty końcowe. Będzie to miało szczególne znaczenie dla ochrony użytkowników i danych w usługach opartych na chmurze. Urządzenia końcowe i widoczność sieci są nadal ważne (jeśli je mamy), ale muszą być rozszerzone o widoczność z góry na dół, jak pokazano na rysunku 5. Będziemy monitorować wszystko tam, gdzie to możliwe – wszystkie działania, interakcje, transakcje i zachowania, które zapewniają świadomość sytuacyjną użytkowników, urządzeń i ich zachowań.

Podsumowując punkt 4 – operacje bezpieczeństwa muszą obejmować ocenę i monitorowanie ryzyka związanego z tożsamością/kontem, danymi i procesami.

Imperatyw #5: Użyj narzędzi analitycznych, AI, automatyzacji i orkiestracji, aby przyspieszyć czas wykrywania i reagowania oraz skalować ograniczone zasoby.

Aby zidentyfikować znaczące wskaźniki ryzyka, dane te należy analizować przy użyciu wielu metod analitycznych, w tym:

- Sygnatury tradycyjne.

- Sygntatury behawioralne.

- Korelacja.

- Techniki oszustwa.

- Dopasowanie wzorców.

- Podstawy i wykrywanie anomalii poprzez porównanie z historycznymi wzorcami zachowań i rówieśnikami (grupami lub organizacjami).

- Analiza powiązań encji.

- Analiza podobieństwa.

- Sieci neuronowe.

- Uczenie maszynowe (nadzorowane i nienadzorowane).

- Głębokie uczenie.

Musimy przyznać, że identyfikacja ryzyka w biznesie cyfrowym będzie wymagać zestawu warstwowych, matematycznych i analitycznych podejść w odniesieniu do stale rosnącego zbioru danych. Techniki takie jak:

- sygnatury i dopasowywanie wzorców wymagają mniejszej mocy obliczeniowej i czasu.

- uczenie maszynowe będą wymagały więcej czasu i będą wymagały użycia historycznych zestawów danych.

Nadmierne poleganie na jednej technice analitycznej lub matematycznej narazi organizacje na niebezpieczeństwo. Najlepsi dostawcy i platformy zabezpieczeń będą używać wielu warstw technik analitycznych, aby lepiej wykrywać i ujawniać znaczące ryzyko, aby skoncentrować nasze ograniczone zasoby na rzeczywistych i ważnych zagrożeniach. Efekt jest podobny do lejka, który obejmuje miliardy zdarzeń i wykorzystuje analizy i kontekst, aby przekształcić je w kilka incydentów o wysokiej pewności, dużej wartości i wysokim ryzyku, na których zespół bezpieczeństwa musi się codziennie koncentrować.

Zasada bezpieczeństwa „defense in depth” musi obejmować metody analityczne „analytics in depth”.

Automatyzacja, orkiestracja i sztuczna inteligencja (AI) przyspieszą nasz czas reakcji. Musimy wykorzystać automatyzację, orkiestrację i AI, aby działały jako mnożnik zasobów Twojego zespołu i ulepszały wydajność i skuteczność naszych ograniczonych zasobów operacji bezpieczeństwa. Nie mamy czasu na badanie każdego incydentu. Analiza dużych zbiorów danych i uczenie maszynowe pozwolą naszym ograniczonym pracownikom skupić się na odpowiedzi na trzy zasadnicze pytania:

- Czy wykryte ryzyko jest prawdziwe?

- Jak jest poziom zagrożenia związany z tym ryzykiem?

- Czy zasoby, które podlegają temu ryzyku są istotne?

Imperatyw #6: Projektowanie bezpieczeństwa IT jako zintegrowanego, zdolnego do adaptacji systemu – zamiast „silosów bezpieczeństwa” punktowo chroniących wrażliwe obszary.

Tradycyjna infrastruktura bezpieczeństwa to ochrona poszczególnych obszarów – dla przykładu – IAM, urządzeń końcowych, sieci czy aplikacji. Z tym podejściem wiąże się wiele problemów:

- Wyciszone elementy sterujące tworzą zbyt wielu dostawców i konsole, zwiększając złożoność i zwiększając ryzyko błędnej konfiguracji.

- Każdy silos nie ma wystarczającego kontekstu do wykrywania z wysokim poziomem pewności, co powoduje utworzenie zbyt wielu alertów. Wiele z nich to fałszywe alarmy lub stanowią one niskie ryzyko.

- Zdarzenia z wyciszonych elementów sterujących są często przekazywane do SIEM, który może, ale nie musi, nadawać sens dodatkowym zdarzeniom (wrzucanie śmieci, usuwanie śmieci). Stwarza to kolejne źródło alertów, z których wiele to fałszywe alarmy lub stanowią one niskie ryzyko.

- Każdy silos nie ma wystarczającego kontekstu do wykrywania z wysokim poziomem pewności, co powoduje utworzenie zbyt wielu alertów. Wiele z nich to fałszywe alarmy lub stanowią one niskie ryzyko.

W rzeczywistości zaawansowane ataki obejmują nasze wewnętrzne obszary bezpieczeństwa a ich efektywne wykrycie wiąże się z korelacją sygnałów z kilku obszarów. Na przykład osoba atakująca przeprowadza atak oparty na wiadomości e-mail:

- Email zawiera adres URL prowadzący do złośliwej zawartości.

- Zawartość jest ładowana na urządzenie końcowe, gdzie atakuje lukę w zabezpieczeniach, aby uruchomić program do monitorowania naciśnięć klawiszy, aby uzyskać dane dostępu.

- Dane dostępusą następnie wykorzystywane do rozprzestrzeniania się na inne systemy, a ostatecznie do uzyskiwania dostępu do wrażliwych danych i ich eksfiltracji.

- Być programami – produkatami software-based, w pełni programowalnymi i dostępnymi za pośrednictwem interfejsów API.

- Mieć możliwość określania kontekstu przy użyciu standardów takich jak STIX, TAXII lub JSON oraz wspierania branżowych centrów udostępniania i analizy informacji, takich jak FS-ISAC, OpenDXL lub pxGrid.

- Umożliwiać ciągłą ocenę poziomu ryzyka, zamiast bazować na bardzo ryzykowanych jednorazowych ocenach dostępu typu zezwól/ odmów.

- Posiadać możliwość składowania i przetwarzania coraz większej ilości danych, ponieważ coraz większa widoczność (a tym samym dane) jest potrzebna do wydajnego i skutecznego podejmowania decyzji dotyczących bezpieczeństwa. Opłaty za zwiększenie storage’u czy możliwości obliczeniowych hamują te decyzje.

- Mieć możliwość określania kontekstu przy użyciu standardów takich jak STIX, TAXII lub JSON oraz wspierania branżowych centrów udostępniania i analizy informacji, takich jak FS-ISAC, OpenDXL lub pxGrid.

Imperatyw #7: Wdrażaj oparte o dane podejmowanie decyzji i odpowiedzialność za ryzyko na poziomie jednostek biznesowych i właścicieli produktów

Nasze procesy zarządzania ryzykiem i zgodności podlegają tym samym ograniczeniom co jednorazowe oceny dostępu typu „zezwól/odmów”, które omawiałem wcześniej. Obecnie zbyt częesto używamy sztywnych i długich procedur oraz list kontrolnych, aby ocenić skuteczność naszego programu bezpieczeństwa. By nadążyć za ewoluującym krajobrazem zagrożeń, powinniśmy odejść od statycznych list kontrolnych i wdrożyć proces oceny poziomu ryzyka – ciągły proces uwzględniający zmiany w linii zachowań w czasie. Ten sposób myślenia jest ujęty w podejściu, które firma Gartner nazywa zintegrowanym zarządzaniem ryzykiem – Integrated Risk Management (zbiór praktyk i procesów wspieranych przez kulturę świadomą ryzyka i technologie wspomagające. Poprawia podejmowanie decyzji i wydajność dzięki zintegrowanemu widokowi, jak dobrze organizacja zarządza swoim unikalnym zestawem ryzyk). IRM zakłada priorytetyzowanie proaktywnego podejścia do wykrywania ryzyka.

Tabela: Proaktywne vs Reaktywne podejście do wykrywania ryzyka

| Proaktywne wykrywanie ryzyka | Reaktywne wykrywanie ryzyka | |

|---|---|---|

| Zarządzanie Ryzykiem | • Jakie nowe cyfrowe inicjatywy biznesowe są planowane? • Jakie są istniejące inicjatywy cyfrowe o niskim progu ryzyka utraty reputacji? • Jakim nowym wymaganiom regulacyjnym podlegam i jaki jest wewnętrzny polityczny apetyt na ich spełnienie? • Jakie są związane z tym zagrożenia cybernetyczne? • Jak poważne są te zagrożenia cybernetyczne? • Jak cenna jest nowa inicjatywa (przychody, koszty, zobowiązania)? • Jakie nowe możliwości biznesowe są dostępne, jeśli zaakceptuję większe ryzyko? • Jakie zobowiązania wobec akcjonariuszy lub innych interesariuszy należy prześledzić wstecz do podejmowania decyzji dotyczących ryzyka związanego z biznesem cyfrowym? | • Jaka jest moja ogólna pozycja ryzyka we wszystkich BU, partnerach, projektach i infrastrukturze? • Gdzie są obszary wysokiego ryzyka? • Gdzie procedury ograniczenia ryzyka nie są przestrzegane i jakie to ma znaczenie? • Jakie aktywa/usługi są zagrożone i jaką mają wartość? • Jakich zabezpieczeń brakuje i jakie to ryzyko? |

Pamiętajmy, że przyjęcie zasady odpowiedzialności właściciela jest kluczowym warunkiem wprowadzenia CARTA do zarządzania ryzykiem. Ostateczna odpowiedzialność za ochronę zasobów informacyjnych przedsiębiorstwa oraz, w konsekwencji, jego procesów biznesowych i wyników, spoczywa na właścicielach biznesowych zasobów informacyjnych. Właściciele zasobów muszą mieć uprawnienia do podejmowania opartych na danych i ryzyku decyzji wymaganych do wywiązania się z ich odpowiedzialności. Oczekiwanie, że zespół ds. bezpieczeństwa IT podejmie te decyzje na akceptowalnym poziomie zaufania i ryzyka w imieniu właściciela procesu czy zasobów , utrudni nie tylo przyjęcie strategicznego podejścia CARTA ale i działalność biznesową wogóle.

Podsumowując – zintegrowana platforma, zapewniająca widoczność i korelację pomiędzy poszczególnymi rozwiązaniami oraz ciągły proces oceny ryzyka użytkownika/urządzenia/konta – to jedynie kwestia czasu i usprawnień technologicznych. Prawidziwym wyzwaniem jest organizacyjne fundament CARTA – przejście do podejmowania decyzji w oparciu o dane w rękach jednostek biznesowych i właścicieli produktów, oraz nastawienie świadome ryzyka to organizacyjny. Zarządzanie bezpieczeństwem i ryzykiem musi stać się zbiorem przeplatających się, ciągłych i adaptacyjnych procesów. Współpracując z jednostkami biznesowymi, definiujemy akceptowalne poziomy zaufania i ryzyka, które przekładają się na wytyczne polityki bezpieczeństwa. Te zasady i dopuszczalne poziomy ryzyka przepływają przez naszą infrastrukturę zabezpieczeń, zmieniając:

- Jak tworzymy i pozyskujemy nowe usługi IT

- Jak oceniamy i oceniamy nowych partnerów cyfrowego ekosystemu biznesowego (którego coraz większa część znajduje się pod naszą kontrolą).

- Jak chronimy i umożliwiamy dostęp do naszych systemów i danych w czasie wykonywania procesów.

- Jak oceniamy i oceniamy nowych partnerów cyfrowego ekosystemu biznesowego (którego coraz większa część znajduje się pod naszą kontrolą).

Podejmowane decyzje dotyczące bezpieczeństwa powinny być stale oceniane (niekoniecznie przez człowieka), aby zapewnić, że poziom ryzyka/zaufania jest zrównoważone do akceptowalnego, które firma i właściciele jednostek biznesowych – a nie dział IT – uznają za stosowne.